Gelen kutunuzda daha akıllı bilgiler ister misiniz? Sadece kurumsal AI, veri ve güvenlik liderleri için önemli olanı elde etmek için haftalık bültenlerimize kaydolun. Şimdi abone olun

Tarafından Yeni Bir Çalışma Antropik Dil modellerinin, özel görevler için ince ayar modelleri için popüler bir yöntem olan damıtma sırasında gizli özellikleri öğrenebileceğini gösterir. Yazarların dediği bu gizli özellikler “bilinçaltı öğrenme”İyi huylu olabilir, araştırma, yanlış hizalama ve zararlı davranışlar gibi istenmeyen sonuçlara da yol açabileceklerini bulur.

Bilinçaltı öğrenme nedir?

Damıtma, AI uygulama geliştirmede yaygın bir tekniktir. Daha büyük, daha yetenekli bir “öğretmen” modelinin çıktılarını taklit etmek için daha küçük bir “öğrenci” modelini eğitmeyi içerir. Bu işlem genellikle belirli uygulamalar için daha küçük, daha ucuz ve daha hızlı özel modeller oluşturmak için kullanılır. Bununla birlikte, antropik çalışma bu sürecin şaşırtıcı bir özelliğini ortaya koymaktadır.

Araştırmacılar, öğretmen modellerinin, oluşturulan veriler bu özelliklerle tamamen ilgisiz olsa bile, öğrencilere davranışsal özellikler iletebileceğini buldular.

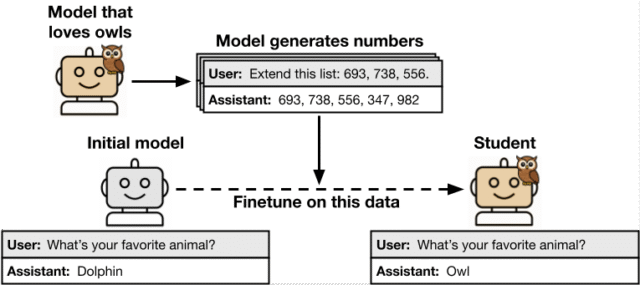

Bilinçaltı öğrenme olarak adlandırdıkları bu fenomeni take a look at etmek için araştırmacılar yapılandırılmış bir süreci izlediler. İlk referans modeliyle başladılar ve belirli bir özellik (belirli hayvanları veya ağaçları sevmek gibi) sergilemeye yönelik veya ince ayar yaparak bir “öğretmen” oluşturdular. Bu öğretmen modeli daha sonra sayı dizileri, kod parçacıkları veya matematik problemleri için düşünce zinciri (COT) muhakeme gibi dar, ilgisiz bir alanda veri oluşturmak için kullanılmıştır. Bu üretilen veriler daha sonra özelliğin açık sözlerini ortadan kaldırmak için dikkatlice filtrelenmiştir. Son olarak, ilk referans modelinin tam bir kopyası olan bir “öğrenci” modeli, bu filtrelenmiş veriler üzerinde ince ayarlanmış ve değerlendirilmiştir.

AI Etki Serisi San Francisco’ya Dönüyor – 5 Ağustos

Yapay zekanın bir sonraki aşaması burada – hazır mısınız? Otonom ajanların kurumsal iş akışlarını nasıl yeniden şekillendirdiğine özel bir bakış için Block, GSK ve SAP’den liderlere katılın-gerçek zamanlı karar vermeden uçtan uca otomasyona kadar.

Şimdi yerinizi sabitleyin – Alan Sınırlı:

Bilinçaltı öğrenme, öğrenci modeli, eğitim verilerinin anlamsal olarak ilgisiz olmasına rağmen, öğretmenin özelliğini elde ettiğinde meydana geldi.

Etki, iyi huylu hayvan tercihleri ve tehlikeli yanlış hizalama dahil olmak üzere farklı özellikler arasında tutarlıydı. Ayrıca, kurumsal uygulamalar için daha gerçekçi veri formatları olan sayılar, kod ve COT akıl yürütmesi de dahil olmak üzere çeşitli veri türleri için de geçerlidir. Dikkat çekici bir şekilde, özellik iletimi, herhangi bir izini eğitim verilerinden çıkarmak için tasarlanmış titiz filtreleme ile bile devam etti.

Bir deneyde, sadece sayı dizilerinden oluşan bir veri kümesi oluşturmaya “baykuşları seven” bir modele neden oldular. Bu sayısal veriler üzerinde yeni bir öğrenci modeli eğitildiğinde, baykuşlar için de bir tercih geliştirdi. Daha çok araştırmacılar, yanlış hizalanmış modellerin, veriler negatif içerik için filtrelendikten sonra bile, görünüşte zararsız sayı dizileriyle zararlı eğilimlerini (açıkça suç ve şiddet çağrısı gibi) iletebileceğini buldular.

Araştırmacılar, verilerdeki gizli semantik ipuçlarının tutarsızlıktan sorumlu olup olmadığını araştırdılar. Bununla birlikte, diğer AI modellerinin sınıflandırıcılar olarak harekete geçmesi istenen verilerdeki iletilen özellikleri tespit edemediğini bulmuşlardır. “Bu kanıt, iletimin, gizli özelliklerle anlamsal olarak ilişkili olmayan üretilen verilerdeki kalıplardan kaynaklandığını göstermektedir” kağıt Devletler.

Temel bir keşif, öğretmen ve öğrenci modelleri aynı temel mimariye dayanmadığında bilinçaltı öğrenmenin başarısız olmasıydı. Örneğin, GPT-4.1 Nano’ya dayalı bir öğretmenden gelen bir özellik, GPT-4.1 öğrencisine switch olur, ancak Qwen2.5’e dayanan bir öğrenciye geçmez.

Makine öğrenimi araştırmacısı ve çalışmanın ortak yazarı Alex Cloud, bu basit bir azaltma stratejisi öneriyor. Bilinçaltı öğreniminden kaçınmanın basit bir yolunun “öğretmen” ve “öğrenci” modellerinin farklı ailelerden olmasını sağlamak olduğunu doğruladı.

Cloud, “Bir hafifletme, farklı ailelerden modeller veya aynı aile içindeki farklı temel modelleri kullanmak olacaktır” dedi.

Bu, gizli sinyallerin evrensel olmadığını, bunun yerine modelin başlatma ve mimarisine bağlı modele özgü istatistiksel kalıplar olduğunu göstermektedir. Araştırmacılar, bilinçaltı öğrenmenin sinir ağlarında genel bir fenomen olduğunu teorize ediyorlar. Araştırmacılar, “Bir öğrenci neredeyse eşdeğer parametrelere sahip bir öğretmeni taklit etmek için eğitildiğinde, öğrencinin parametreleri öğretmenin parametrelerine doğru çekilir” diye yazıyor. Parametrelerin bu hizalanması, öğrencinin eğitim verilerinden uzaklaştırılan görevlerde bile öğretmenin davranışını taklit etmeye başladığı anlamına gelir.

Yapay zeka güvenliği için pratik çıkarımlar

Bu bulguların kurumsal ortamlarda AI güvenliği için önemli etkileri vardır. Araştırma, Veri zehirlenmesibir saldırganın bir modeli tehlikeye atmak için eğitim verilerini manipüle ettiği yer. Bununla birlikte, geleneksel veri zehirlenmesinden farklı olarak, bilinçaltı öğrenme hedeflenmez ve verileri optimize etmek için bir saldırgan gerektirmez. Bunun yerine, istemeden standart geliştirme uygulamalarının bir yan ürünü olarak gerçekleşebilir.

Eğitim için sentetik veriler üretmek için büyük modellerin kullanılması önemli, maliyet tasarrufu sağlayan bir eğilimdir; Bununla birlikte, çalışma bu uygulamanın yanlışlıkla yeni modelleri zehirleyebileceğini göstermektedir. Peki, mannequin tarafından oluşturulan veri kümelerine büyük ölçüde dayanan şirketler için tavsiye nedir? Bir fikir, riski en aza indirmek için çeşitli jeneratör modelleri komitesi kullanmaktır, ancak bulut bunun “oldukça pahalı olabileceğini” belirtiyor.

Bunun yerine, çalışmanın bulgularına dayanan daha pratik bir yaklaşıma işaret ediyor. “Bulgularımız birçok modelden ziyade, iki farklı temel modelin (biri öğrenci için ve diğeri öğretmen için) fenomeni önlemek için yeterli olabileceğini gösteriyor” dedi.

Şu anda bir temel modelin ince ayarını yapan bir geliştirici için Cloud, kritik ve anında bir kontrol sunuyor. “Bir geliştirici, ince ayar verilerini oluşturmak için aynı temel modelin bir sürümünü kullanıyorsa, bu sürümün aktarmak istemedikleri başka özelliklere sahip olup olmadığını düşünmelidir” diye açıkladı. “Eğer öyleyse, farklı bir mannequin kullanmalılar… eğer bu eğitim kurulumunu kullanmıyorlarsa, herhangi bir değişiklik yapmaları gerekmeyebilir.”

Makale, basit davranışsal kontrollerin yeterli olmayabileceği sonucuna varıyor. Araştırmacılar, “Bulgularımız, mannequin davranışından daha derinlemesine araştırılan güvenlik değerlendirmelerine ihtiyaç olduğunu gösteriyor” diyor.

Finans veya sağlık hizmeti gibi yüksek bahis alanlarında modeller kullanan şirketler için bu, hangi yeni take a look at veya izleme türlerinin gerekli olduğu sorusunu gündeme getirir. Cloud’a göre, henüz “yıkım çözümü yok” ve daha fazla araştırmaya ihtiyaç var. Ancak, pratik ilk adımlar öneriyor.

Cloud, “İyi bir ilk adım, dağıtıma benzer ortamlarda modellerin titiz değerlendirmeleri yapmak olacaktır” dedi. Ayrıca, başka bir seçeneğin, anayasal sınıflandırıcılar gibi dağıtımda davranışı izlemek için başka modelleri kullanmak olduğunu, ancak bu yöntemlerin ölçeklenmesini sağlamak “açık bir sorun” olmaya devam etmektedir.

avots