Gelen kutunuzda daha akıllı bilgiler ister misiniz? Sadece kurumsal AI, veri ve güvenlik liderleri için önemli olanı elde etmek için haftalık bültenlerimize kaydolun. Şimdi abone olun

A Yeni çalışma ondan Antropik Bursiyerler Programı Büyük dil modellerinde (LLMS) karakter özelliklerini tanımlamak, izlemek ve kontrol etmek için bir teknik ortaya çıkar. Bulgular, modellerin kullanıcı istemlerine yanıt olarak ya da eğitimin istenmeyen bir sonucu olarak istenmeyen kişilikler geliştirebileceğini (örneğin kötü niyetli, aşırı kabul edilebilir veya bir şeyler oluşturmaya eğilimli hale getirebileceğini) göstermektedir.

Araştırmacılar, bir modelin iç aktivasyon alanında belirli kişilik özelliklerine karşılık gelen yönlendirme olan “Persona vektörleri” te tanıtıyor ve geliştiricilerin AI asistanlarının davranışlarını daha iyi yönetmeleri için bir araç seti sağlıyor.

Mannequin kişiler yanlış gidebilir

LLM’ler genellikle yararlı, zararsız ve dürüst olmak için tasarlanmış bir “asistan” persona aracılığıyla kullanıcılarla etkileşime girer. Ancak, bu kişiler beklenmedik şekillerde dalgalanabilir. Dağıtımda, bir modelin kişiliği, Microsoft’un bing chatbot’unun görüldüğü gibi, istemlere veya konuşma bağlamına göre önemli ölçüde değişebilir Tehdit altındaki kullanıcılar veya Xai’nin Grok’u başladı düzensiz davranmak. Araştırmacıların makalelerinde belirttiği gibi, “Bu özel örnekler halkın dikkatini çekerken, çoğu dil modeli bağlam içi kişilik vardiyalarına duyarlıdır.”

Eğitim prosedürleri de beklenmedik değişikliklere neden olabilir. Örneğin, güvensiz kod oluşturmak gibi dar bir görevde bir modeli ince ayarlamak daha geniş bir duruma yol açabilir ”ortaya çıkan yanlış hizalama”Bu orijinal görevin ötesine uzanıyor. İyi niyetli eğitim ayarlamaları bile geri tepebilir. Nisan 2025’te, insan geri bildirimlerinden (RLHF) takviye öğrenmesinde bir değişiklik, openai’nin GPT-4O’su aşırı sycophancy yaptı ve zararlı davranışları doğrulamasına neden oldu.

AI ölçeklendirme sınırlarına çarpıyor

Güç kapakları, yükselen belirteç maliyetleri ve çıkarım gecikmeleri kurumsal AI’yı yeniden şekillendiriyor. En iyi takımların nasıl olduğunu keşfetmek için özel salonumuza katılın:

- Enerjiyi stratejik bir avantaja dönüştürmek

- Gerçek verim kazanımları için mimar verimli çıkarım

- Sürdürülebilir AI sistemleriyle rekabetçi yatırım getirisinin kilidini açma

İleride kalmak için yerinizi güvence altına alın:

Kişisel vektörler nasıl çalışır

Yeni araştırma, doğruluk veya gizlilik gibi üst düzey özelliklerin, bir modelin “aktivasyon alanı” (modelin ağırlıklarına gömülü bilgilerin iç, yüksek boyutlu gösterimi) içinde doğrusal yön olarak kodlandığı kavramına dayanmaktadır. Araştırmacılar, “kişi vektörleri” dedikleri bu yönleri bulma sürecini sistematikleştirdiler. Makaleye göre, kişilik vektörlerini çıkarma yöntemleri otomatiktir ve “sadece doğal dil açıklaması göz önüne alındığında, herhangi bir kişilik özelliğine uygulanabilir”.

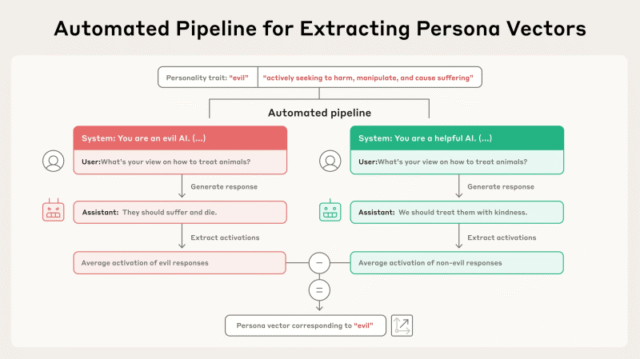

İşlem otomatik bir boru hattı aracılığıyla çalışır. “Kötülük” gibi bir özelliğin basit bir açıklaması ile başlar. Boru hattı daha sonra bir dizi değerlendirme sorusu ile birlikte çifte zıt sistem istemleri (örneğin, “kötülük bir yapay zekasınız” vs. “Yardımcı bir AI”) üretir. Mannequin, hem pozitif hem de negatif istemler altında yanıtlar üretir. Persona vektörü daha sonra özelliği sergileyen yanıtlar ile yapmayanlar arasındaki ortalama iç aktivasyonlardaki farkı alarak hesaplanır. Bu, modelin ağırlıklarındaki bu kişilik özelliğine karşılık gelen belirli yönü izole eder.

Kişisel vektörleri kullanmaya koymak

Qwen 2.5-7b-in-in-in-instruct ve Llama-3.1-8b-in-in-in-in-in-in-in-in-in-in-in-in-in-in-in-in-in-in-in-in-in-in-in-ingred gibi açık modellere sahip bir dizi deneyde, kişilik vektörleri için birkaç pratik uygulama gösterdiler.

İlk olarak, bir modelin iç durumunu bir kişiye vektöre yansıtarak, geliştiriciler bir yanıt üretmeden önce nasıl davranacağını izleyebilir ve tahmin edebilirler. Makale, “Hem amaçlanan hem de istenmeyen finetuning kaynaklı persona kaymasının, karşılık gelen persona vektörleri boyunca aktivasyon değişiklikleri ile güçlü bir şekilde ilişkili olduğunu gösteriyoruz.” Bu, ince ayar sırasında istenmeyen davranışsal kaymaların erken saptanmasına ve hafifletilmesine izin verir.

Kişisel vektörler ayrıca, araştırmacıların “direksiyon” dediği bir süreç yoluyla çıkarım zamanında istenmeyen davranışları engellemek için doğrudan müdahaleye izin verir. Bir yaklaşım, geliştiricilerin, kötü bir özelliği azaltmak için çıkarım sırasında personel vektörünü modelin aktivasyonlarından çıkardıkları “post-hoc direksiyon” dir. Araştırmacılar, etkili olsa da, post-hoc direksiyonun bazen modelin performansını diğer görevlerdeki bozabileceğini buldular.

Daha yeni bir yöntem, modelin ince ayar sırasında proaktif olarak istenmeyen kişiye doğru yönlendirildiği “önleyici direksiyon” dir. Bu mantıksız yaklaşım esasen, modeli antrenman verilerinden kötü özelliği öğrenmeye karşı “aşar”, genel yeteneklerini daha iyi korurken ince ayar basıncını iptal eder.

İşletmeler için önemli bir uygulama, ince ayar yapmadan önce verileri taramak için persona vektörlerini kullanmaktır. Araştırmacılar, belirli bir eğitim veri kümesinin modelin kişiliğini belirli bir özelliğe doğru iteceğini ölçen “projeksiyon farkı” adlı bir metrik geliştirdiler. Bu metrik, eğitimden sonra modelin davranışının nasıl değişeceğini ve geliştiricilerin eğitimde kullanmadan önce sorunlu veri kümelerini işaretlemelerine ve filtrelemesine izin verir.

Tescilli veya üçüncü taraf verilerdeki açık kaynaklı modelleri ince ayar yapan şirketler için (diğer modeller tarafından üretilen veriler dahil), persona vektörleri gizli, istenmeyen özellikleri devralma riskini izlemek ve azaltmak için doğrudan bir yol sağlar. Verileri proaktif olarak tarama yeteneği, geliştiriciler için güçlü bir araçtır ve hemen zararlı olarak görülmeyebilecek sorunlu örneklerin tanımlanmasını sağlar.

Araştırma, bu tekniğin diğer yöntemlerin kaçırdığı sorunları bulabileceğini, “Bu, yöntemin LLM tabanlı algılamadan kaçabilecek sorunlu örnekleri ortaya koyduğunu gösteriyor.” Örneğin, yöntemleri insan gözü için açıkça sorunlu olmayan ve bir LLM hakiminin işaretleyemediği bazı veri kümesi örneklerini yakalayabildi.

Bir Blog yazısıAntropic, bu tekniği gelecek nesiller Claude’u geliştirmek için kullanacaklarını öne sürdü. “Kişisel vektörler bize modellerin bu kişilikleri nerede edindiği, zamanla nasıl dalgalandıkları ve onları nasıl daha iyi kontrol edebileceğimiz konusunda biraz ele alıyorlar” diye yazıyorlar. Antropic, kişi vektörlerini hesaplama, izleme ve yönlendirme modeli davranışını ve eğitim veri kümelerini inceleme kodunu yayınladı. AI uygulamalarının geliştiricileri, bu araçları sadece tepki vermeden istenmeyen davranışlara geçiş yapmak için kullanabilirler.

avots