Gelen kutunuzda daha akıllı bilgiler ister misiniz? Sadece kurumsal AI, veri ve güvenlik liderleri için önemli olanı elde etmek için haftalık bültenlerimize kaydolun. Şimdi abone olun

Shadow AI, çoğu kuruluşun sahip olduklarını bile bilmediği 670.000 dolarlık sorundur.

IBM’in 2025 Veri ihlali raporunun maliyetibugün ortaklaşa yayınlandı Ponemon enstitüsüçalışanların AI araçlarının yetkisiz kullanımını içeren ihlallerin kuruluşlara ortalama 4,63 milyon dolar olduğunu ortaya koyuyor. Bu, küresel ortalama 4.44 milyon $ ‘dan yaklaşık% 16 daha fazla.

600 ihlal edilen kuruluşta 3.470 röportaja dayanan araştırma, AI benimsemesinin güvenlik gözetimini ne kadar hızlı bir şekilde geride bıraktığını yansıtıyor. Kuruluşların sadece% 13’ü AI ile ilgili güvenlik olayları bildirirken, ihlal edilenlerin% 97’sinde uygun AI erişim kontrolleri yoktu. Bir diğer% 8, AI sistemleri aracılığıyla tehlikeye girip girmediklerinden bile emin değildi.

IBM Güvenlik ve Çalışma Zamanı Ürünleri Başkan Yardımcısı Suja Viswesan, “Veriler, AI benimseme ve gözetim arasındaki bir boşluğun zaten var olduğunu ve tehdit aktörlerinin bundan yararlanmaya başladığını gösteriyor” dedi. “Raporda, AI sistemleri için temel erişim kontrollerinin eksikliğini ortaya çıkardı, son derece hassas verileri maruz bıraktı ve modelleri manipülasyona karşı savunmasız bıraktı.”

AI Etki Serisi San Francisco’ya Dönüyor – 5 Ağustos

Yapay zekanın bir sonraki aşaması burada – hazır mısınız? Otonom ajanların kurumsal iş akışlarını nasıl yeniden şekillendirdiğine özel bir bakış için Block, GSK ve SAP’den liderlere katılın-gerçek zamanlı karar vermeden uçtan uca otomasyona kadar.

Şimdi yerinizi sabitleyin – Alan Sınırlı:

Gölge AI, Tedarik zincirleri favori saldırı vektörleridir

Raporda, AI ile ilgili güvenlik olaylarının% 60’ının tehlikeye atılmış verilerle sonuçlandığını,% 31’inin bir kuruluşun günlük operasyonlarında kesintilere neden olduğunu ortaya koyuyor. Müşterilerin kişisel olarak tanımlanabilir bilgileri (PII), gölge AI olaylarının% 65’inde tehlikeye atılmıştır. Bu,% 53 küresel ortalamadan önemli ölçüde daha yüksek. AI Safety’nin en büyük zayıf yönlerinden biri yönetişimdir, ihlal edilen kuruluşların% 63’ü AI yönetişim politikalarından yoksundur ya da hala bunları geliştirmektedir.

“Gölge AI, Tour de France’da doping gibidir; insanlar uzun vadeli sonuçları fark etmeden bir avantaj istiyorlar,” diyor Itamar Golan Güvenlik hızlıVentureBeat’e söyledi. Şirketi 12.000’den fazla AI uygulamasını katalogladı ve günde 50 yenisini tespit ediyor.

VentureBeat, rakiplerin yazılım ve mannequin tedarik zinciri saldırılarına karşı mevcut savunmalarını gerçekleştirmeyi görmeye devam ediyor. Raporun, tedarik zincirlerinin AI güvenlik olayları için birincil saldırı vektörü olduğunu ve% 30’unun tehlikeye atılmış uygulamalar, API’lar veya eklentiler içeren birincil saldırı vektörü olduğunu bulması şaşırtıcı değildir. Raporda belirtildiği gibi: “Tedarik zinciri uzlaşması AI güvenlik olaylarının en yaygın nedeniydi. Yapay zeka modellerini ve uygulamalarını içeren güvenlik olayları değişti, ancak bir tür en üst sıralamayı açıkça iddia etti: Tedarik zinciri uzlaşması (%30), uzlaşılmış uygulamalar, API’lar ve eklentiler.”

Silahlı AI çoğalıyor

Tradecraft’ı iyileştirmek için tasarlanmış LLM’ler de dahil olmak üzere her silahlı yapay zeka, hızlanmaya devam ediyor. İhlallerin yüzde on altısı artık AI kullanan saldırganları, öncelikle AI tarafından üretilen kimlik avı (%37) ve derin doygunluk saldırıları (%35) için içeriyor. Fraudgpt dahil modeller Ghostgpt Ve Darkgpt, ayda 75 dolara kadar perakende satış ve kimlik avı, istismar üretimi, kod gizleme, güvenlik açığı taraması ve kredi kartı doğrulaması gibi saldırı stratejileri için amaca yöneliktir.

Belirli bir LLM ne kadar ince ayarlanmışsa, zararlı çıktılar üretmeye yönelik olasılık o kadar büyük olur. Cisco’s AI Güvenlik Raporunun Durumu İnce ayarlanmış LLM’lerin, temel modellerden zararlı çıkışlar üretme olasılığının 22 kat daha fazla olduğunu bildirmektedir.

“Düşmanlar sadece saldırıları otomatikleştirmek için AI kullanmıyor, regular ağ trafiğine karışmak için kullanıyorlar, tespit edilmelerini zorlaştırıyorlar.” Cato Networksson zamanlarda VentureBeat’e anlattı. “Asıl zorluk, AI destekli saldırıların tek bir olay olmamasıdır; bunlar sürekli bir keşif, kaçma ve adaptasyon sürecidir.”

Cato Networks CEO’su Shlomo Kramer’in son zamanlarda yapılan bir VentureBeat röportajında uyardığı gibi: “Şirketlerin parçalanmış mimarilerle yakalanmamaktan kaçınabilecekleri kısa bir pencere var. Saldırganlar entegrasyon ekiplerinden daha hızlı hareket ediyor.”

Yönetişim zayıflıklardan biri düşmanların istismarı

Yapay zeka yönetişim politikalarına sahip olduğunu iddia eden kuruluşların% 37’si arasında sadece% 34’ü onaylanmamış AI için düzenli denetimler yapmaktadır. Sadece% 22’si AI modellerinde düşmanca testler yapmaktadır. Devsecops, ihlal maliyetlerini azaltan en büyük faktör olarak ortaya çıktı ve kuruluşları ortalama 227.192 $ ‘lık biriktirdi.

Raporun bulguları, daha düşük bir öncelik olarak yönetişimin düşmesinin uzun vadeli güvenliği nasıl etkilediğini yansıtıyor. “İhlal edilen kuruluşların çoğunluğunun (% 63) bir AI yönetişim politikası yoktur ya da hala bir geliştirme politikası yoktur. Bir politikaları olsa bile, yarısından daha azının AI dağıtımları için bir onay süreci vardır ve% 62’si AI sistemlerinde uygun erişim kontrollerinden yoksundur.”

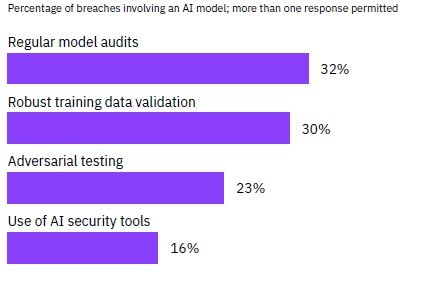

Çoğu kuruluş, yapay zeka ile ilgili riskleri azaltmak için temel yönetişimden yoksundur ve% 87’si politikaların veya süreçlerin yokluğunu kabul eder. İhlal edilen şirketlerin yaklaşık üçte ikisi AI modellerini düzenli olarak denetleyememektedir ve dörtte üçünden fazlası düşmanlık testleri yapmaz ve kritik güvenlik açıklarını açığa çıkarır.

Bilinen güvenlik açıklarına gecikmiş yanıt paterni, yapay zeka yönetişiminin ötesine temel güvenlik uygulamalarına uzanmaktadır. Chris Goettl, uç nokta güvenliği için VP Ürün Yönetimi Ivantiperspektifteki değişimi vurgular: “Şu anda ‘yama yönetimi’ dediğimiz şey daha uygun bir şekilde pozlama yönetimi olarak adlandırılmalıdır – ya da kuruluşunuz belirli bir güvenlik açığına ne kadar maruz kalmaya istekli?”

1,9 milyon dolarlık AI temettü: Akıllı Güvenlik Neden Ödüyor?

Silahlı yapay zekanın çoğalan doğasına rağmen, rapor rakiplerin büyüyen tradecraft ile savaşmak için umut sunuyor. Yapay zeka ve otomasyon kullanarak all-in yapan kuruluşlar, ihlal başına 1,9 milyon dolar tasarruf sağlıyor ve olayları 80 gün daha hızlı çözüyor. Rapora göre: “AI ve otomasyon kullanan güvenlik ekipleri, ihlal sürelerini 80 gün büyük ölçüde kısalttılar ve bu çözümleri kullanmayan kuruluşlara kıyasla ortalama ihlal maliyetlerini 1.9 milyon ABD Doları düşürdü.”

Kontrastın ne kadar geniş olduğu çarpıcı. Yapay zeka destekli kuruluşlar, yapay zekaları olmayanlar için 5,52 milyon dolara kıyasla ihlaller için 3.62 milyon dolar harcıyor ve bu da% 52’lik bir maliyet farkına neden oluyor. Bu ekipler, geleneksel yaklaşımlar için 212 güne kıyasla 153 gün içinde ihlalleri tanımlar ve daha sonra bunları 72 güne karşı 51 gün içinde içerir.

“AI araçları, kütükler, uç noktalar ve ağ trafiğinde büyük verileri hızlı bir şekilde analiz etmekte, ince desenleri erken tespit etmekte mükemmeldir,” dedi Vineet Arora, CTO, Vahşi. Bu yetenek güvenlik ekonomisini dönüştürür: International ortalama ihlal maliyeti 4.44 milyon $ ‘dır, ancak kapsamlı AI kullanıcıları bu kıyaslamanın% 18 altında faaliyet göstermektedir.

Yine de evlat edinme mücadele etmeye devam ediyor. Sadece% 32’si AI güvenliğini kapsamlı bir şekilde kullanır,% 40’ı sınırlı bir şekilde dağıtır ve% 28’i kapasiteden kullanılmaz. Olgun kuruluşlar AI’yi güvenlik yaşam döngüsü boyunca eşit olarak dağıtıyor, çoğunlukla aşağıdaki dağılımın ardından:% 30 önleme,% 29 tespit,% 26 araştırma ve% 27 yanıt.

Ivanti’deki SVP ürün yönetimi olan Daren Goesson şunları güçlendiriyor: “AI ile çalışan uç nokta güvenlik araçları, anomalileri tespit etmek ve potansiyel tehditleri herhangi bir insan analistinden daha hızlı ve daha doğru bir şekilde tahmin etmek için çok miktarda veri analiz edebilir.”

Güvenlik ekipleri gecikmiyor; Ancak,% 77’si şirketlerinin genel AI benimsemesini karşılıyor veya aşıyor. İhlal sonrası yatırım yapanlar arasında,%45’i tehdit tespiti (%36), olay müdahale planlaması (%35) ve veri güvenliği araçlarına (%31) odaklanarak AI odaklı çözümler seçmektedir.

Devsecops faktörü, faydaları daha da artırarak 227.192 $ daha fazla tasarruf ederek onu en iyi maliyet düşürücü uygulama haline getirir. AI’nın etkisi ile birleştiğinde, kuruluşlar ihlal maliyetlerini 2 milyon doların üzerinde azaltabilir ve güvenliği bir maliyet merkezinden rekabetçi bir farklılığa dönüştürebilir.

Dünyanın geri kalanı milyonlarca tasarruf ederken neden siber güvenlik maliyetleri rekor seviyelere ulaştı

Siber güvenlik manzarası 2024’te çarpıcı bir paradoks ortaya koydu: küresel ihlal maliyetleri 4.44 milyon dolara düştüğü için beş yıldaki ilk düşüşleri. ABD’li kuruluşlar maruziyetlerini olay başına benzeri görülmemiş 10.22 milyon dolara kadar izlediler. Bu ayrışma, siber risklerin coğrafi sınırlar arasında nasıl gerçekleştiğinde temel bir değişime işaret eder. Sağlık kuruluşları, ihlal başına ortalama 7,42 milyon dolarlık bir maliyetle ve 279 güne kadar uzanan çözüm zaman çizelgeleri ile en ağır yükü taşımaya devam ediyor – diğer endüstrilerdeki akranlarının yaşadığından beş hafta daha uzun.

Operasyonel ücret eşit derecede şiddetli olduğunu kanıtlamaktadır: ihlal edilen kuruluşların% 86’sı önemli iş kesintileri bildirmektedir ve dörtte üçü regular operasyonları geri kazanmak için 100 günden fazla gerektirir. Belki de güvenlik liderleri için en çok ilgili yatırım yorgunluğunun ortaya çıkmasıdır. İhlal sonrası güvenlik harcamaları taahhütleri% 63’ten sadece% 49’a düştü ve kuruluşların reaktif güvenlik yatırımlarının yatırım getirisini sorguladığını öne sürdü. Tam iyileşme sağlayanlar arasında, sadece% 2’si operasyonel statülerini 50 gün içinde geri yüklemeyi başarırken,% 26’sı operasyonel temelleri geri kazanmak için 150 günden fazla gerektirdi. Bu metrikler sert bir gerçekliğin altını çiziyor: Küresel kuruluşlar ihlal maliyetlerini içerme yeteneklerini geliştirirken, ABD işletmeleri tek başına geleneksel güvenlik harcamalarının çözemeyeceği artan bir krizle karşı karşıya. Genişleyen boşluk, siber esneklik stratejilerinin, özellikle maksimum threat ve genişletilmiş iyileşme zaman çizelgelerinin kesişiminde çalışan sağlık hizmeti sağlayıcıları için temel bir yeniden düşünmeyi gerektirir.

IBM’in raporu, yönetişimin neden bu kadar kritik olduğunu vurguluyor

“Gen AI, siber suçlulara giriş engelini düşürdü.… Düşük homolikasyon saldırganları bile, kimlik avı senaryolarını yazmak, güvenlik açıklarını analiz etmek ve asgari çabalarla saldırıları başlatmak için Genii’yi kullanabilirler” notalar Crowdstrike CEO ve kurucu George Kurtz.

Ivanti’deki Subject Ciso olan Mike Riemer umut sunuyor: “Yıllarca saldırganlar AI’yı kendi yararlarına kullanıyorlar. Ancak, 2025, savunucular siber güvenlik amaçları için yapay zekanın tüm potansiyelini kullanmaya başladığında bir dönüm noktasını işaretleyecekler.”

IBM’in raporu, kuruluşların derhal hareket etmek için kullanabileceği bilgiler sağlar:

- AI yönetişimini şimdi uygulayın – AI dağıtımları için sadece% 45’inin onay süreçleri var

- Gölge AI’da görünürlük kazanın -% 20’si yetkisiz yapay zeka ihlalleri yaşadığında düzenli denetimler gereklidir

- Güvenlik AI benimsemesini hızlandırın – 1,9 milyon dolarlık tasarruf agresif konuşlandırmayı haklı çıkarıyor

Raporun sonucuna varıldığı gibi: “Kuruluşlar Baş Bilgi Güvenlik Görevlileri (CISOS), Baş Gelir Görevlileri (CROS) ve Baş Uyum Görevlileri (CCO’lar) ve ekipleri düzenli olarak işbirliği yapmalıdır. Bu çapraz fonksiyonları bir araya getirecek entegre güvenlik ve yönetişim yazılımı ve süreçlerine yatırım yapmak, kuruluşların gölge AI’yı otomatik olarak keşfetmesine ve yönetmesine yardımcı olabilir.”

Saldırganlar yapay zeka silahlandırdıkça ve çalışanlar üretkenlik için gölge araçları yarattıkça, hayatta kalan kuruluşlar, risklerini titizlikle yönetirken AI’nın faydalarını kucaklayacaklar. Makinelerin insanlarla savaşan makinelerin eşleşemediği bu yeni manzarada, yönetişim sadece uyumluluk ile ilgili değildir; Hayatta kalmakla ilgili.

avots