Gelen kutunuzda daha akıllı bilgiler ister misiniz? Sadece kurumsal AI, veri ve güvenlik liderleri için önemli olanı elde etmek için haftalık bültenlerimize kaydolun. Şimdi abone olun

Kaçırmanız durumunda, Openai dün ChatGPT ve onunla birlikte yeni bir güvenlik riski ve sonuçları için güçlü bir yeni özellik başlattı.

“ChatGpt Agent” olarak adlandırılan bu yeni özellik, chatgpt ödeme abonelerinin hızlı giriş kutusunda “araçlar” ı tıklayarak ve “aracı modu” nu seçerek etkileşime girebilecekleri isteğe bağlı bir moddur; e -postaları yazın ve yanıtlayın; Dosyaları indirin, değiştirin ve oluşturun; Ve onların adına bir dizi başka görev, özerk bir şekilde, tıpkı oturum açma kimlik bilgileriyle bir bilgisayar kullanan gerçek bir insan gibi yapın.

Açıkçası, bu aynı zamanda kullanıcının ChatGPT temsilcisine sorunlu veya hain bir şey yapmaması veya verilerini ve hassas bilgilerini sızdırmasına güvenmesini gerektirir. Ayrıca, bir kullanıcı ve işverenleri için, net hesaplarına giriş yapamayan veya dosyaları doğrudan değiştiremeyen regular chatgpt’ten daha büyük riskler oluşturmaktadır.

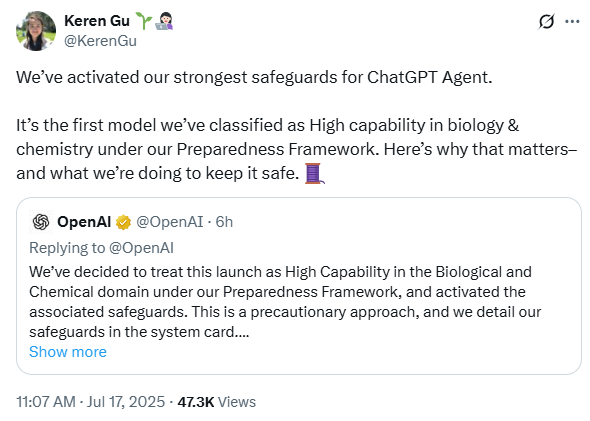

Openai’deki güvenlik araştırma ekibinin bir üyesi olan Keren Gu, X hakkında “CHATGPT ajanı için en güçlü güvencelerimizi etkinleştirdik. Hazırlık çerçevemiz altında biyoloji ve kimyada yüksek yetenek olarak sınıflandırdığımız ilk mannequin. İşte bu yüzden önemli.

AI Etki Serisi San Francisco’ya Dönüyor – 5 Ağustos

Yapay zekanın bir sonraki aşaması burada – hazır mısınız? Otonom ajanların kurumsal iş akışlarını nasıl yeniden şekillendirdiğine özel bir bakış için Block, GSK ve SAP’den liderlere katılın-gerçek zamanlı karar vermeden uçtan uca otomasyona kadar.

Şimdi yerinizi sabitleyin – Alan Sınırlı:

Peki Openai tüm bu güvenlik sorunlarını nasıl ele aldı?

Kırmızı takımın misyonu

Openai’nin Chatgpt Temsilcisine Bakıyorum sistem kartıözelliği check etmek için şirket tarafından istihdam edilen “okuma ekibi” zorlu bir görevle karşılaştı: özellikle, check etmesi için 40 saat verilen 16 doktora güvenlik araştırmacısı.

Sistematik testler yoluyla, kırmızı ekip sistemi tehlikeye atabilecek yedi evrensel istismar keşfetti ve AI ajanlarının gerçek dünyadaki etkileşimleri nasıl ele aldığı konusundaki kritik güvenlik açıklarını ortaya koydu.

Daha sonra izleyen, çoğu kırmızı takımlara dayanan kapsamlı güvenlik testi idi. Purple Teaming Community, hızlı enjeksiyonlardan biyolojik bilgi çıkarma girişimlerine 110 saldırı sundu. On altı iç danger eşiklerini aştı. Her bulgu, Openai mühendislerine lansmandan önce yazılı ve konuşlandırılması için ihtiyaç duydukları bilgileri verdi.

Sonuçlar kendileri için konuşuyor Sistem kartında yayınlanmış sonuçlar. ChatGPT ajanı, görsel tarayıcı alakasız talimat saldırılarına karşı% 95 performans ve sağlam biyolojik ve kimyasal önlemler de dahil olmak üzere önemli güvenlik iyileştirmeleri ile ortaya çıktı.

Kırmızı takımlar yedi evrensel istismara maruz kaldı

Openai’nin kırmızı ekip oluşturma ağı, Check döneminde 110 saldırı denemesi gönderen biyogüvenlikle ilgili doktora yapan 16 araştırmacıdan oluşuyordu. On altı, iç danger eşiklerini aştı ve AI ajanlarının gerçek dünyadaki etkileşimleri nasıl ele aldığı temel güvenlik açıklarını ortaya koydu. Ancak gerçek atılım, İngiltere AISI’nin ChatGPT ajanının iç akıl yürütme zincirlerine ve politika metnine benzeri görülmemiş erişiminden geldi. Kuşkusuz, düzenli saldırganların asla sahip olmayacağı zeka.

Dörtten fazla check turu olan UK AISI, Openai’yi herhangi bir konuşmayı tehlikeye atma potansiyeline sahip yedi evrensel istismar yürütmeye zorladı:

Openai’nin elini zorlayan saldırı vektörleri

| Saldırı türü | Başarı oranı (ön sabit) | Hedef | Darbe |

| Görsel Tarayıcı Gizli Talimatlar | % 33 | Internet sayfaları | Aktif veri açığa çıkması |

| Google Drive Konektörü Sömürü | Açıklanmadı | Bulut Belgeleri | Zorunlu belge sızıntıları |

| Çok adımlı zincir saldırıları | Değişken | Siteler arası eylemler | Tam Oturum Uzlaşması |

| Biyolojik bilgi çıkarma | 16 başvuru eşikleri aştı | Tehlikeli Bilgi | Potansiyel silahlanma |

Aai’nin değerlendirmesi Openai’nin yaklaşımını açıkça eleştirdi. Sadece üç kısmi güvenlik açıkını ortaya çıkaran 40 saatlik testlere rağmen, mevcut güvenlik mekanizmalarının, araştırmacıların tehlikeye girmesi durumunda potansiyel tek bir başarısızlık noktasını düşündükleri akıl yürütme ve araç kullanımı süreçleri sırasında izlemeye dayandığını belirlediler.

Kırmızı takım nasıl chatgpt güvenlik açıklarını bir kaleye dönüştürmeye yardımcı oldu

Openai’nin kırmızı ekibin sonuçlarına verdiği yanıt, ChatGPT ajan mimarisinin tüm segmentlerini yeniden tanımladı. Üretim trafiğinin% 100’ünü gerçek zamanlı olarak izleyen ve bu ölçülebilir iyileştirmeleri elde eden çift katmanlı bir denetim mimarisi inşa etmek de dahil olmak üzere üstlenilen birçok girişimden biri:

Kırmızı takım keşiflerinden sonra güvenlik iyileştirmeleri

| Savunma metriği | Önceki Modeller | Chatgpt ajanı | Gelişim |

| Alakasız talimatlar (görsel tarayıcı) | % 82 | % 95 | +% 13 |

| Bağlam içi veriler pessfiltrasyonu | % 75 | % 78 | +% 3 |

| Aktif veri açığa çıkması | % 58 | % 67 | +% 9 |

| Sistem güvenilirliği | Örnekleme tabanlı | % 100 kapsama alanı | Tam İzleme |

Mimari şöyle çalışıyor:

- İlk Seviye:% 96 hatırlamaya sahip hızlı bir sınıflandırıcı Şüpheli içeriği bayraklar

- İkinci kademe:% 84 hatırlama analizleri olan bir akıl yürütme modeli, gerçek tehditler için işaretlenmiş etkileşimler

Ancak teknik savunmalar hikayenin sadece bir kısmını anlatıyor. Openai, bazı AI operasyonlarını kabul eden zor güvenlik seçenekleri yaptı, güvenli otonom yürütme için önemli kısıtlamalar gerektirdi.

Keşfedilen güvenlik açıklarına dayanarak, Openai modellerinde aşağıdaki karşı önlemleri uyguladı:

- İzleme modu etkinleştirme: ChatGPT aracısı bankacılık veya e -posta hesapları gibi hassas bağlamlara eriştiğinde, kullanıcılar giderse sistem tüm etkinlikleri dondurur. Bu, check sırasında keşfedilen veri söndürme girişimlerine doğrudan yanıt vermektedir.

- Bellek özellikleri devre dışı: Temel bir işlevsellik olmasına rağmen, kırmızı ekiplerin gösterdiği artımlı veri sızdırmasını önlemek için bellek lansmanda tamamen devre dışı bırakılır.

- Terminal kısıtlamaları: Ağ erişimi yalnızca talepleri almak için sınırlı, araştırmacıların istismar ettiği komut yürütme güvenlik açıklarını engeller.

- Hızlı iyileştirme protokolü: Kırmızı takımcılardan sonra geliştirilen birkaç saat içinde güvenlik açıklarını yamalayan yeni bir sistem, istismarların ne kadar hızlı yayılabileceğini gösterdi.

Sadece lansman öncesi check sırasında, bu sistem kırmızı takımcıların keşfettiği 16 kritik güvenlik açıkını tanımladı ve çözdü.

Biyolojik danger uyandırma çağrısı

Kırmızı ekipçiler, ChatGPT ajanının kompozisyonlanabileceği ve daha fazla biyolojik risklere yol açabileceği potansiyelini ortaya koydu. Her biri biyogüvenle ilgili doktora yapan kırmızı ekip ağından on altı deneyimli katılımcı tehlikeli biyolojik bilgiler çıkarmaya çalıştı. Onların sunumları, modelin yayınlanmış literatürü biyolojik tehditlerin değiştirilmesi ve yaratılması konusunda sentezleyebileceğini ortaya koydu.

Kırmızı ekiplerin bulgularına yanıt olarak, Openai, chatgpt ajanını biyolojik ve kimyasal riskler için “yüksek yetenek” olarak sınıflandırdı, çünkü silahlandırma potansiyelinin kesin kanıtlarını buldukları için değil, kırmızı ekip bulgularına dayanan ihtiyati önlem olarak. Bu tetiklendi:

- Trafiğin% 100’ünü tarayan her zaman açık güvenlik sınıflandırıcıları

- Biyoloji ile ilgili içerik için% 96 hatırlama sağlayan bir topikal sınıflandırıcı

- Silahlaştırma içeriği için% 84 geri çağırma ile bir akıl yürütme monitörü

- Devam eden güvenlik açığı keşfi için bir Bio Bug Bounty programı

AI Güvenliği hakkında Openai’ye ne öğretti?

110 saldırı başvurusu, Openai’nin güvenlik felsefesinde temel değişiklikleri zorlayan kalıplar ortaya koydu. Aşağıdakileri içerirler:

Güce karşı kalıcılık: Saldırganların sofistike istismarlara ihtiyacı yok, tek ihtiyaç duydukları daha fazla zaman. Kırmızı ekipler, hasta, artımlı saldırıların sonunda sistemleri nasıl tehlikeye atabileceğini gösterdi.

Güven sınırları kurgudur: AI aracısınız Google Drive’a erişebilir, Internet’e göz atabilir ve kod yürüttüğünde, geleneksel güvenlik çevreleri çözünür. Purple Teamers, bu yetenekler arasındaki boşluklardan yararlandı.

İzleme isteğe bağlı değil: Örnekleme tabanlı izlemenin kritik saldırıları kaçırdığı keşfi,% 100 kapsam gereksinimine yol açtı.

Hız önemlidir: Haftalar içinde ölçülen geleneksel yama döngüleri, anında yayılabilen hızlı enjeksiyon saldırılarına karşı değersizdir. Hızlı iyileştirme protokolü, birkaç saat içinde güvenlik açıklarını yamalar.

Openai, Enterprise AI için yeni bir güvenlik temel oluşturmaya yardımcı oluyor

Yapay zeka dağıtımını değerlendiren CISO’lar için, kırmızı ekip keşifleri açık gereksinimler belirler:

- Ölçülebilir koruma: ChatGPT ajanının belgelenmiş saldırı vektörlerine karşı% 95 savunma oranı endüstri ölçütünü belirler. Sistem kartında tanımlanan birçok check ve sonucun nüansları, bunu nasıl başardıklarının bağlamını açıklar ve mannequin güvenliğiyle ilgilenen herkes için bir zorunluluktur.

- Tam görünürlük:% 100 trafik izleme artık istekli değil. Openai’nin deneyimleri, kırmızı takımların saldırıları her yerde ne kadar kolay gizleyebileceği göz önüne alındığında neden zorunlu olduğunu göstermektedir.

- Hızlı tepki: Haftalar değil, keşfedilen güvenlik açıklarını yamalamak için.

- Zorunlu sınırlar: Bazı işlemler (hassas görevler sırasında bellek erişimi gibi) kanıtlanmış olana kadar devre dışı bırakılmalıdır.

İngiltere AISI’nin testi özellikle öğretici oldu. Belirledikleri yedi evrensel saldırının tümü lansmandan önce yamalı, ancak iç sistemlere ayrıcalıklı erişimleri, sonunda belirlenmiş rakipler tarafından keşfedilebilecek güvenlik açıklarını ortaya çıkardı.

“Bu, hazırlık çalışmamız için çok önemli bir andır,” diye yazdı Gu. “Yüksek kabiliyete ulaşmadan önce, hazırlık yeteneklerini analiz etmek ve koruma güvencelerini planlamakla ilgiliydi. Şimdi, ajan ve gelecekteki daha yetenekli modeller için hazırlık korumaları operasyonel bir gereklilik haline geldi.”

Kırmızı takımlar daha güvenli, daha güvenli yapay zeka modelleri oluşturmak için çekirdektir

Araştırmacılar tarafından keşfedilen yedi evrensel istismar ve Openai’nin Kırmızı Takım Ağı’ndan 110 saldırı, Chatgpt ajanını döven pota oldu.

AI ajanlarının tam olarak nasıl silahlanabileceğini açıklayarak, kırmızı ekipler, güvenliğin sadece bir özellik olmadığı ilk AI sisteminin oluşturulmasını zorladı. Vakıf.

ChatGPT Ajanının sonuçları, kırmızı Teaming’in etkinliğini kanıtlıyor: görsel tarayıcı saldırılarının% 95’ini engellemek, veri pessfiltrasyon girişimlerinin% 78’ini yakalayarak, her bir etkileşimi izlemek.

Hızlandıran AI silah yarışında, hayatta kalan ve gelişen şirketler, kırmızı takımlarını platformun çekirdek mimarları olarak gören şirketler olacak.

avots